با ظهور و پیشرفت ویدیوهای تولید شده توسط هوش مصنوعی، بسیاری از کارشناسان پیشبینی میکنند که یادگیری ماشین میتواند به مرگ صنعت سینما به شکل کنونیاش منجر شود. برخی تصور میکنند که سازندگان مستقل میتوانند فیلمهای پرفروش هالیوودی را از خانه یا با استفاده از سیستمهای گرافیکی مبتنی بر ابر بسازند.

آیا این امکانپذیر است؟ حتی اگر ممکن باشد، آیا واقعاً به زودی محقق خواهد شد؟

اینکه آیا افراد توانایی ساخت فیلمهایی مانند آنچه اکنون داریم با شخصیتهای ثابت، تداوم داستان و واقعگرایی کامل را پیدا میکنند، کاملاً ممکن و شاید حتی اجتنابناپذیر است.

با این حال، چندین دلیل اساسی وجود دارد که نشان میدهد این احتمال به سادگی در سیستمهای ویدیویی مبتنی بر مدلهای یادگیری عمیق به وقوع نخواهد پیوست.

این واقعیت مهم است زیرا در حال حاضر، این دسته شامل تمامی سیستمهای محبوب تبدیل متن به ویدیو (T2) و تصویر به ویدیو (I2V) میشود، از جمله مدلهایی مانند Minimax، Kling، Sora، Imagen، Luma، ویدیو ژنراتور آمازون، Runway ML، Kaiber و به زودی Adobe Firefly؛ و بسیاری دیگر.

در اینجا، ما به بررسی چشمانداز تولیدات کامل ویدیوهای هوش مصنوعی میپردازیم که توسط افراد خلق شدهاند، با شخصیتهای ثابت و جلوههای بصری که حداقل همسطح با وضعیت فعلی هنر در هالیوود است.

بیایید نگاهی به برخی از بزرگترین موانع عملی در برابر این چالشها بیندازیم.

1: شما نمیتوانید یک عکس بعدی دقیق دریافت کنید

یکی از بزرگترین موانع در تولید ویدیو، مشکل ناهماهنگی روایی است. واقعیت این است که هیچیک از سیستمهای تولید ویدیویی که در حال حاضر وجود دارد، نمیتواند یک عکس «دنبالهدار» واقعی و دقیق ایجاد کند.

این مشکل به دلیل این است که مدلهای استفادهشده در این سیستمها به نویز تصادفی متکی هستند، و این اصل اصلی نمیتواند به طور دقیق همان محتوا را دوباره تفسیر کند. به عبارت دیگر، نمیتوان یک صحنه را از زوایای مختلف یا با توسعه یک عکس قبلی به تصویر بعدی تبدیل کرد و در عین حال سازگاری با عکس قبلی را حفظ کرد.

زمانی که از اعلانهای متنی یا تصاویر «بذر» (seed) استفاده میشود، این اعلانها به مدل کمک میکنند تا محتوای معنایی مناسب را از فضای آموزشی خود استخراج کند. اما به دلیل وجود «نویز تصادفی»، این فرایند هرگز بهطور دقیق تکرار نمیشود.

این یعنی هویت افراد در ویدیو تغییر خواهد کرد و اشیا و محیطها با عکس اولیه همخوانی نخواهند داشت.

به همین دلیل، کلیپهای ویروسی که جلوههای بصری شگفتانگیز و خروجی در سطح هالیوود را نشان میدهند، معمولاً یا به صورت تکشات هستند یا به صورت «مونتاژ ویترینی» از قابلیتهای سیستم، جایی که هر عکس شخصیتها و محیطهای متفاوتی دارد.

مفهوم این مجموعه از نسلهای ویدئویی موقت (که ممکن است در سیستمهای تجاری غیرواقعی باشد) این است که سیستم اصلی میتواند روایتهای پیوسته و قابل قبولی ایجاد کند.

برای توضیح این موضوع، میتوان به تریلر یک فیلم اشاره کرد که تنها یک یا دو دقیقه از فیلم را نمایش میدهد، اما به مخاطب این احساس را میدهد که کل فیلم وجود دارد.

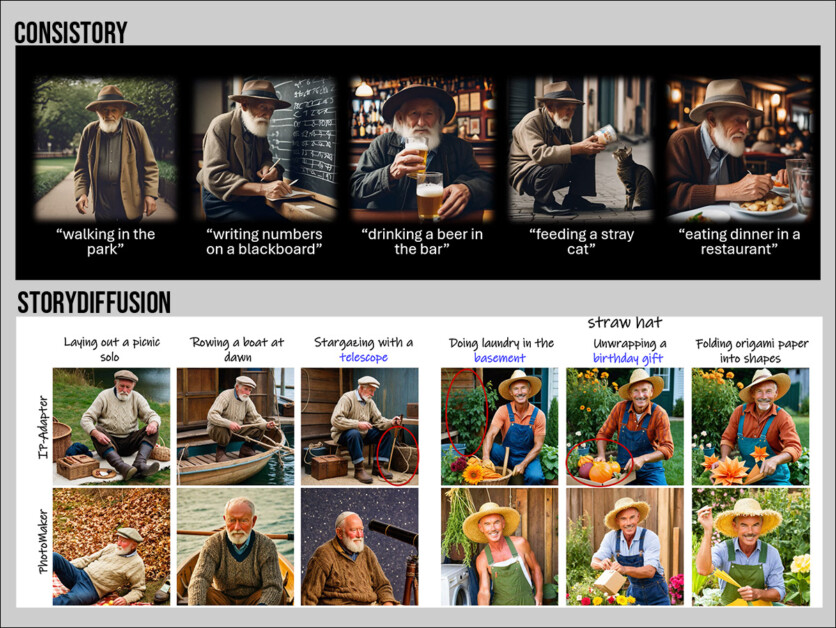

تنها سیستمهایی که در حال حاضر میتوانند سازگاری روایی را در مدلهای انتشار ارائه دهند، سیستمهایی هستند که تصاویر ثابت تولید میکنند. این شامل ConsiStory از انویدیا و پروژههای مختلف دیگری در ادبیات علمی مانند TheaterGen، DreamStory و StoryDiffusion میشود.

در تئوری، میتوان از نسخههای بهتری از این سیستمها استفاده کرد (اما هیچکدام از موارد ذکر شده واقعاً سازگار نیستند) تا یک سری عکسهای تبدیل شده به ویدیو ایجاد کرد که بتوان آنها را در کنار هم در یک سکانس قرار داد.

اما در وضعیت فعلی هنر، این روش نمیتواند تصاویر دنبالهدار و قابل قبولی تولید کند. بهعلاوه، ما با افزودن پیچیدگیها، از رویای تولید مستقل دور شدهایم.

همچنین میتوانیم از مدلهای انطباق با رتبه پایین (LoRA) استفاده کنیم که بهطور خاص بر روی شخصیتها، اشیا یا محیطها آموزش داده شدهاند تا هماهنگی بهتری بین عکسها حفظ شود.

اما اگر شخصیتی بخواهد در یک لباس جدید ظاهر شود، معمولاً باید یک LoRA کاملاً جدید آموزش داده شود که شخصیت را با آن لباس تجسم کند. (اگرچه میتوان مفاهیم فرعی مانند "لباس قرمز" را بهصورت جداگانه با تصاویر مشابه آموزش داد، اما کار با آنها همیشه آسان نیست).

این موضوع پیچیدگی قابل توجهی به صحنههای ساده در یک فیلم اضافه میکند. به عنوان مثال، یک صحنه که در آن شخصی از رختخواب بلند میشود، لباس مجلسی میپوشد، خمیازه میکشد، از پنجره به بیرون نگاه میکند و به حمام میرود، تقریباً شامل 4 تا 8 پلان است.

این صحنهها میتوانند به راحتی در یک صبح با روشهای معمول فیلمسازی ضبط شوند. اما در وضعیت فعلی هوش مصنوعی مولد، تولید چنین صحنههایی ممکن است هفتهها زمان، چندین LoRA آموزشدیده (یا سیستمهای کمکی دیگر) و مقدار قابل توجهی پسپردازش نیاز داشته باشد.

به عنوان یک گزینه دیگر، میتوان از ویدیو به ویدیو استفاده کرد، جایی که فیلمهای معمولی یا CGI از طریق پیامهای متنی به تفسیرهای جایگزین تبدیل میشوند. بهعنوان مثال، Runway چنین سیستمی را ارائه میدهد.

در اینجا دو مشکل وجود دارد:

اول اینکه شما باید فیلم اصلی را ابتدا بسازید، بنابراین در واقع دو بار فیلم را تولید میکنید، حتی اگر از سیستمهای مصنوعی مانند MetaHuman شرکت UnReal استفاده کنید.

دوم اینکه اگر مدلهای CGI را بسازید (مانند کلیپ بالا) و از آنها برای تبدیل ویدیو به تصویر استفاده کنید، نمیتوانید به ثبات آنها در بین عکسها اعتماد کنید.

این مشکل به این خاطر است که مدلهای پخش ویدیو «تصویر کلی» را نمیبینند؛ بلکه تنها یک فریم جدید را بر اساس فریمهای قبلی ایجاد میکنند و در برخی موارد، یک فریم نزدیک به آینده را هم در نظر میگیرند. اما اگر این روند را با بازی شطرنج مقایسه کنیم، این مدلها نمیتوانند «ده حرکت جلوتر» فکر کنند و نمیتوانند ده حرکت را به عقب برگردانند.

علاوه بر این، یک مدل انتشار همچنان برای حفظ ظاهری ثابت در سراسر عکسها تلاش میکند، حتی اگر چندین LoRA برای شخصیت، محیط و سبک نور اضافه کنید. این مشکلات به دلایلی که در ابتدای این بخش گفته شد، همچنان وجود دارند.

2: شما نمیتوانید یک عکس را به راحتی ویرایش کنید

اگر شخصیتی را در حال قدم زدن در خیابان با استفاده از روشهای قدیمی CGI به تصویر میکشید و تصمیم بگیرید که بخواهید برخی از جنبههای عکس را تغییر دهید، میتوانید مدل را تنظیم کنید و دوباره آن را رندر کنید.

اگر فیلمبرداری واقعی باشد، کافی است آن را ریست کرده و دوباره با تغییرات مناسب، عکس بگیرید.

اما اگر یک شات ویدیویی با هوش مصنوعی تولید میکنید که خوشتان آمده، اما میخواهید یک جنبه از آن را تغییر دهید، تنها راه این است که از روشهای سخت و وقتگیر پس از تولید استفاده کنید. این روشها شامل CGI، روتوسکوپی، مدلسازی و حصیر کردن میشوند که همگی مراحل کار فشرده و پرهزینهای هستند و در طی 30 تا 40 سال گذشته توسعه یافتهاند.

روش کار مدلهای انتشار به این صورت است که تغییر یک جنبه از یک اعلان متنی (حتی اگر از یک تصویر اولیه هم استفاده کنید) میتواند جنبههای مختلف خروجی تولید شده را تغییر دهد. این باعث میشود که شما به نوعی در یک بازی «بزن و در برو» گرفتار شوید، جایی که هر تغییر میتواند نتایج غیرمنتظرهای داشته باشد.

3: شما نمیتوانید به قوانین فیزیک تکیه کنید

روشهای سنتی CGI مدلهای مبتنی بر فیزیک الگوریتمی را ارائه میدهند که میتوانند پدیدههایی مانند دینامیک سیالات، حرکت گازی، حرکت انسان، دینامیک پارچه، انفجارها و دیگر پدیدههای دنیای واقعی را شبیهسازی کنند.

با این حال، روشهای مبتنی بر انتشار، همانطور که دیدیم، حافظههای کوتاهی دارند و همچنین تنها میتوانند از محدوده محدودی از حرکات پیشرو استفاده کنند. این حرکات، نمونههایی از دادههای آموزشی موجود هستند.

در نسخه قبلی صفحه فرود OpenAI برای سیستم تحسینشده Sora، این شرکت به محدودیتهای Sora در این زمینه اشاره کرد (اگرچه این متن از آن زمان حذف شده است):

Sora ممکن است در شبیهسازی فیزیک یک صحنه پیچیده دچار مشکل شود و نتواند برخی از روابط علت و معلولی را درک کند. به عنوان مثال، ممکن است یک کوکی بعد از گاز زدن شخصیت، هیچ علامتی نشان ندهد.

این مدل همچنین ممکن است در تشخیص جزئیات فضایی موجود دچار اشتباه شود، مانند تشخیص چپ و راست، یا در توصیف دقیق رویدادهایی که به تدریج ظاهر میشوند، مانند مسیرهای خاص دوربین، با مشکل مواجه شود.

استفاده عملی از سیستمهای ویدئویی مولد مبتنی بر API نیز محدودیتهای مشابهی در شبیهسازی دقیق فیزیک نشان میدهد. با این حال، برخی پدیدههای رایج مانند انفجارها به نظر میرسد که بهتر در دادههای آموزشی آنها نشان داده شدهاند.

برخی حرکات قبلی، یا در مدل مولد آموزش داده شده یا از یک ویدیو منبع تغذیه میشوند، ممکن است زمانبر باشند تا به طور کامل اجرا شوند. به عنوان مثال، شخصی که یک سکانس رقص پیچیده و غیرتکراری را با لباسی زیبا اجرا میکند. در اینجا، انتشار توجه نزدیک مدل ممکن است جزئیات مانند شناسایی چهره و جزئیات لباس را تغییر دهد تا زمانی که حرکت اجرا شود. با این حال، استفاده از LoRA میتواند تا حدی این مشکلات را کاهش دهد.

نتیجهگیری

هیچیک از این موارد برای کاربری که به دنبال ساخت فیلمهای تمامقد به سبک بلاکباستر، با دیالوگهای طبیعی، هماهنگی لب، اجراهای واقعی، محیطهای مناسب و تداوم در تولید است، امیدوارکننده نیست.

علاوه بر این، موانعی که در اینجا توضیح داده شدند، بهویژه در مورد مدلهای ویدیویی مولد مبتنی بر انتشار، به راحتی قابل حل نیستند. این در حالی است که نظرات جامعه و توجه رسانهها ممکن است اینطور به نظر برسد. به نظر میرسد محدودیتهای ذکر شده، ویژگیهای ذاتی این معماریها هستند.

در تحقیقات مربوط به هوش مصنوعی، مانند سایر تحقیقات علمی، ایدههای درخشان گاهی ما را با پتانسیلهای خود شگفتزده میکنند، اما در ادامه تحقیقاتی انجام میشود که محدودیتهای بنیادی آنها را کشف میکند.

در دنیای مولد و سنتز، این موضوع قبلاً با شبکههای متخاصم مولد (GANs) و میدانهای تابشی عصبی (NeRF) رخ داده است. با وجود سالها تحقیق دانشگاهی، دستیابی به ابزارهای کارآمد در سیستمهای تجاری برای این فناوریها بسیار دشوار بود و اکنون اغلب به عنوان اجزای کمکی در معماریهای دیگر به کار میروند.

در حالی که استودیوهای فیلم ممکن است امیدوار باشند که آموزش کاتالوگهای فیلم دارای مجوز قانونی بتواند هنرمندان VFX را جایگزین کند، هوش مصنوعی در حال حاضر به نیروی کار نقشهای جدیدی اضافه میکند.

اینکه آیا سیستمهای ویدیویی مبتنی بر انتشار واقعاً میتوانند به تولیدکنندگان فیلم کمک کنند تا روایتی سازگار و واقعگرایانه ایجاد کنند یا اینکه این صنعت تنها یک جستوجوی دیگر در دنیای کیمیاگری است، باید در 12 ماه آینده مشخص شود.

ممکن است ما به یک رویکرد کاملاً جدید نیاز داشته باشیم. یا ممکن است تکنیک پاشیدن گاوسی (GSplat)، که در اوایل دهه 1990 توسعه یافت و اخیراً در زمینه سنتز تصویر مطرح شده است، یک جایگزین بالقوه برای تولید ویدیوهای مبتنی بر انتشار باشد.

از آنجایی که GSplat 34 سال طول کشید تا به میدان بیاید، شاید رقبای قدیمیتری مانند NeRF و GAN و حتی مدلهای انتشار پنهان هنوز فرصتهای زیادی برای ظهور داشته باشند.