در هفتهی گذشته در زمینهی هوش مصنوعی، DeepMind، آزمایشگاه تحقیق و توسعه هوش مصنوعی متعلق به گوگل، یک مقاله منتشر کرده که چارچوبی برای ارزیابی خطرات اجتماعی و اخلاقی سیستمهای هوش مصنوعی ارائه میدهد. این مقاله به تعدادی مسئله مهم در زمینه اخلاقی و اجتماعی هوش مصنوعی پرداخته و پیشنهاداتی برای ارزیابی و ممیزی اثرات این فناوری در جامعه ارائه میدهد. این اقدام از سوی DeepMind نشان دهنده توجه شرکت به جنبههای اخلاقی و اجتماعی هوش مصنوعی و نقش آن در جامعه است.

همچنین در هفته آینده، اجلاس ایمنی هوش مصنوعی برگزار میشود که با حمایت دولت بریتانیا برگزار میشود. این رویداد شامل حضور دولتها، شرکتهای پیشرو هوش مصنوعی، گروههای جامعه مدنی و کارشناسان در تحقیقات هوش مصنوعی است و هدف اصلی آن تبادل نظر در مورد بهترین راهکارهای مدیریت خطرات ناشی از پیشرفتهای هوش مصنوعی و توسعه یک گروه مشورتی جهانی در زمینه هوش مصنوعی است. این نهاد مشاورهای جهانی به تولید گزارشها و مطالعات دورهای در زمینه پیشرفتهای هوش مصنوعی و اثرات اجتماعی و اخلاقی آن خواهد پرداخت. این نشان میدهد که حکومتها و ارگانهای بینالمللی نیز به جدیت موضوعات اخلاقی و اجتماعی هوش مصنوعی توجه دارند.

این تحولات نشان میدهد که مسائل اخلاقی و اجتماعی مرتبط با هوش مصنوعی در دنیا به تدریج به یک موضوع مهم تبدیل شده و شرکتها و دولتها به دنبال راهحلهای مناسب برای مدیریت این چالشها هستند. این گامهای اخیر نشاندهنده توجه و تعهد به ایجاد یک زمینه پایدار و اخلاقی برای توسعه هوش مصنوعی در جامعه است.

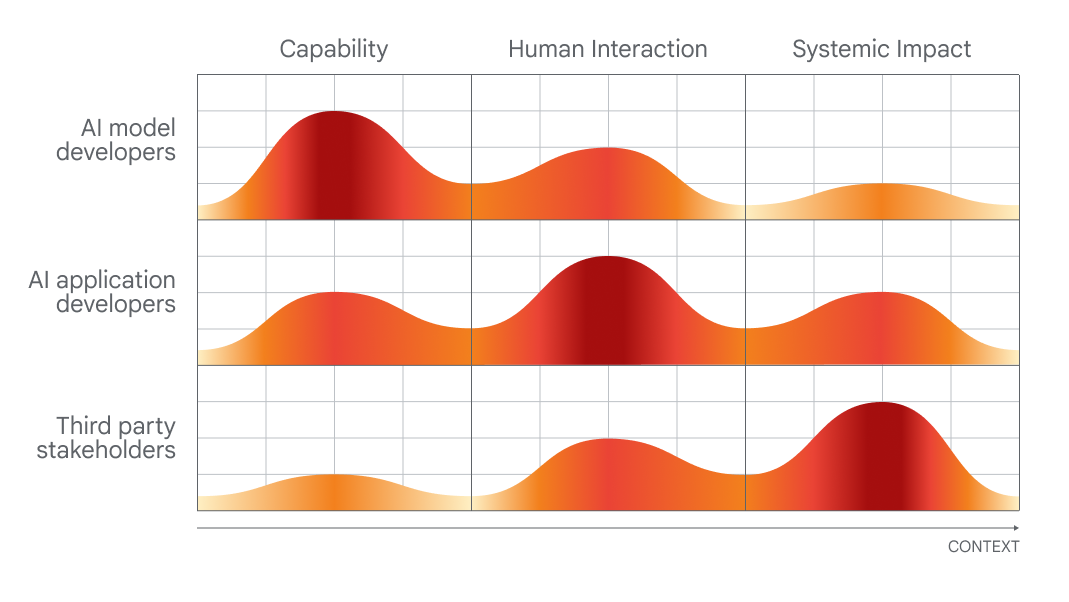

DeepMind، آزمایشگاه تحقیق و توسعه هوش مصنوعی متعلق به گوگل، به تازگی مقالهای منتشر کرده که چارچوبی برای ارزیابی مسائل اخلاقی و اجتماعی در سیستمهای هوش مصنوعی ارائه میدهد. این مقاله به تعامل توسعهدهندگان هوش مصنوعی، توسعهدهندگان اپلیکیشنها و جامعه عامه در فرآیند ارزیابی و بازبینی هوش مصنوعی اشاره دارد.

آزمایشگاه DeepMind در حالی که به اجلاس ایمنی هوش مصنوعی که به همت دولت بریتانیا برگزار میشود، شتاب داده تا تمرکز روی بهترین روشها برای مدیریت خطرات ناشی از پیشرفتهای هوش مصنوعی را بر روی رویای دولت بریتانیا از ایجاد یک گروه مشورتی جهانی برای هوش مصنوعی به عمل آورد. این گروه مشورتی باید مشابه هیئت بیندولتی سازمان ملل متحد برای تغییرات آب و هوایی عمل کند و توسط یک گروه از دانشگاهیان تشکیل شده باشد که گزارشهای منظمی در مورد پیشرفتهای هوش مصنوعی و خطرات آن ارائه میدهند.

DeepMind به منظور تعزیز شفافیت و شفافیت معماری و عملکرد مدلهای هوش مصنوعی خود، اقدام به ارائه اطلاعات دقیقتری از جزئیات داخلی مدلهایش مینماید. به عبارت دیگر، در حال تلاش برای افزایش شفافیت در ارتباط با جامعه هوش مصنوعی و بهبود اطلاعرسانی است. این نشان از اهمیت مسائل اخلاقی در توسعه هوش مصنوعی دارد و نشانگر توجه آزمایشگاه DeepMind به این مسائل است.

این هفته در دنیای هوش مصنوعی، موضوعات جالبی مورد توجه قرار گرفتهاند:

- مایکروسافت تحقیقی انجام داده است که نشان میدهد قابلیت GPT-4 از مدلهای زبان بزرگ دیگر، به ویژه امکان تولید متنهای مخرب، بیشتر است. این مسأله به اهمیت موضوع امنیت در مدلهای هوش مصنوعی اشاره دارد.

- OpenAI ویژگی مرور اینترنت را به ChatGPT اضافه کرده و نسخه بتای DALL-E 3 را منتشر کرده است. این توسعهها نشان از پیشرفتهای این شرکت در زمینه هوش مصنوعی هستند.

- آمازون اعلام کرده که آزمایش ربات دوپایی Agility، Digit، را در تاسیسات خود آغاز خواهد کرد، که به نظر میآید گامی مهم در جهت بهبود فرآیندهای انبار داشته باشد.

- از آنجایی که تنشهای ژئوپلیتیکی بین ایالات متحده و چین در حال افزایش است، دولت آمریکا اقداماتی اعلام کرده که محدودیتهایی را برای صادرات تراشههای هوش مصنوعی به چین اعمال میکند.

- در دنیای سرگرمی، برخی از حسابهای TikTok از هوش مصنوعی برای ساخت نسخههای پاپ معروف تاریخی با موسیقی جدید استفاده میکنند. این موضوع یک پلتفرم سرگرمی جذاب را به وجود میآورد.

این موارد نشان از تلاشها و پیشرفتهای مهم در زمینه هوش مصنوعی در دنیا دارند.

یکی از پیروزیهای جالب در حوزه آموزههای هوش مصنوعی این است که سیستمهای آکادمیک قادر به بررسی مقالات و ارائه پیشنهادهای مرتبط با استنادها در ویکیپدیا شدهاند. این سیستم ممکن است نتواند اختیار داشته باشد که چه اطلاعاتی صحیح و واقعی هستند، اما میتواند از متون مقالات و استنادهای ویکیپدیا با کیفیت بالا استفاده کند و در جستجوی گزینههای مناسب و جایگزین بهرهوری کند. البته هیچکس پیشنهاد نمیدهد که روباتها به تنهایی مسئولیت اجرای دایرهالمعارف آنلاین معروف و محبوب ویکیپدیا را بپذیرند، اما این سیستم میتواند به بهبود مقالاتی کمک کند که استنادهای کافی ندارند یا ویراستاران از صحت آنها مطمئن نیستند.

مدلهای زبان اکنون به خوبی قابل تنظیم برای موضوعات مختلف هستند و در زمینهی ریاضی نیز عملکرد قابل توجهی دارند. Llemma مثالی از مدل باز جدید است که بر روی اثباتهای ریاضی و مقالات مرتبط با آن کار کرده و توانایی حل مسائل نسبتاً پیچیده را دارد. این کارها همچنین توسط Minerva از Google Research و مدلهای مشابه دیگر انجام میشود، اما موفقیت Llemma نشان میدهد که مدلهای باز همچنان در مسابقه و پیشرفت در این فضا دارند. این مهم است تا اینکه نوعی از هوش مصنوعی تحت سلطه مدلهای خصوصی نشوند و تنوع در مدلهای باز حفظ شود. در واقع، تکرار قابلیتها و عملکردهای مدلهای باز حتی اگر زمینه جدیدی را ایجاد نکند، همچنان ارزشمند است.

متأسفانه، در برخی موارد، مطالعات آکادمی به سمت تبدیل مفاهیم ویژهای را به کد کامپیوتری پیش میبرند، به طوری که انگار که ذهن انسان را مستقیماً درک میکنند. برای مثال، در مقاله "رمزگشایی مغز: به سمت بازسازی لحظهای ادراک بصری"، ممکن است به نظر بیاید که آنها به خواندن مستقیم ذهن انسان میپردازند.

اینجا رویکرد یکم غیر مستقیمتری دارد. این کار از طریق مطالعه اسکنهای مغزی با فرکانس بالا وقتی افراد به تصاویر خاصی مانند اسب یا هواپیما نگاه میکنند، انجام میشود. از این طریق محققان میتوانند وضعیت ذهنی و تصاویری که فرد در آن لحظه در ذهن دارد را بازسازی کنند. اما هوش مصنوعی مولد در اینجا نقشی ایفا میکند که چگونه میتواند تصاویر بصری مرتبط با آن فکرها را ایجاد کند، حتی اگر مستقیماً با اسکنها مطابقت نداشته باشد.

سوالی که پیش میآید این است که آیا میتوان از هوش مصنوعی برای خواندن ذهن انسانها استفاده کرد؟ این موضوع مورد بررسی بسیاری از پژوهشها و مطالعات آکادمی قرار گرفته است. DeepMind و دیگر موسسات نیز در این زمینه تحقیقات مختلفی انجام میدهند.

در آخرین پروژه، LAION به نام "یادگیری چند زبانه متضاد برای بازنمایی صوتی" یا CLARA در حال تلاش برای بهبود درک مدلهای زبانی از تفاوتهای ظریف گفتار انسان است. این پروژه سعی دارد با استفاده از کتابخانهای از صدا و متن در چندین زبان، تفاوتهای احساسی و نشانههای غیرکلامی در گفتار را شناسایی کند. این تلاش میکند تا ماشینها بتوانند بهتر از گذشته از طعنه یا فیب و نشانههای غیرکلامی مانند لحن و تلفظ درک کنند، که این برای تعاملات بین انسان و هوش مصنوعی اهمیت دارد.